AIフェイクが現実そっくりに メアリー・ミーカー報告書が示すリスク

AIが生み出す会話や画像、そして人間そっくりの顔が、現実とほとんど見分けがつかなくなりつつあります。2025年5月に公表されたメアリー・ミーカー氏のAI報告書は、こうしたハイパーリアルなフェイクが広がる現在を整理し、「見ても信じられない」時代の姿を示しています。

ハイパーリアルなAIフェイクとは

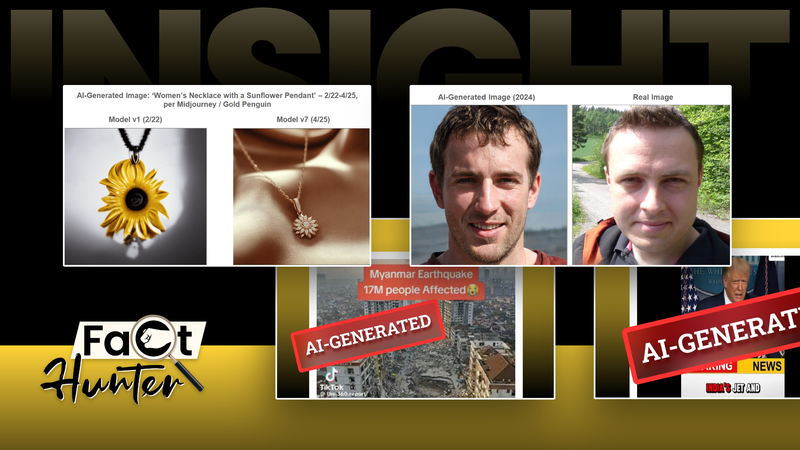

報告書が焦点を当てるのは、人工知能が作り出す合成コンテンツです。テキストの会話、写真のような画像、実在しない人の顔まで、コンピューターが自動で生成したものが、私たちのSNSやニュースフィードの中にごく自然に紛れ込むようになりました。

パッと見ただけでは、人の手によるものかAIによるものか、ほとんど区別がつきません。「見たから本物だ」とは、もはや言い切れない状況になりつつあります。

メアリー・ミーカー氏のTrends – Artificial Intelligence

この状況を整理するための手がかりとなるのが、ベンチャーキャピタリストで元ウォール街アナリストのメアリー・ミーカー氏による報告書「Trends – Artificial Intelligence」です。1995年から続くインターネット関連の動向分析で「インターネットの女王」とも呼ばれてきた人物です。

ミーカー氏は2025年5月、約6年ぶりとなる本格的なレポートを発表しました。全340ページに及ぶ今回の版は、テーマを人工知能に絞り込み、AIが経済や社会、情報環境に与える影響を多面的に捉えています。

デジタルの大きな変化を早い段階で見抜いてきた実績から、このAIレポートは、ハイパーリアルな合成コンテンツの台頭を考えるうえで信頼できる参考資料と位置づけられています。

人間の文章と勘違いされるAI会話

AIチャットボットは、いまや人間と会話しているかのような自然な文章を生成できるようになっています。画面の向こう側にいるのが人なのかAIなのか、日常的なやり取りの中では判断がつかない場面も増えています。

こうした能力を測る指標のひとつが、AIが人間と見分けがつかないかどうかを試すチューリングテストと呼ばれる考え方です。評価する側が、目の前の文章を書いたのが人かAIかを当てられるかどうかを確かめます。

また、カリフォルニア大学サンディエゴ校の最近の実験では、参加者が見たAIの回答のおよそ73%が、人間が書いたものだと誤って判断されました。多くの人が、自分の目と感覚だけではAIと人間を見分けられなかったということになります。

この数字は、ニュースサイトのコメント欄やSNSで目にする文章の一部がAIによるものであっても、多くの人が気づかない可能性を示唆しています。読み手の側の「見抜く力」だけに頼るのは難しい段階に入っていると言えます。

「見ても信じられない」時代の読み方

では、こうしたAI時代の情報環境とどう付き合えばよいのでしょうか。報告書が示す現状を踏まえると、ニュース読者として意識しておきたいポイントがいくつか見えてきます。

- 見た目の本物らしさだけで判断しない – 写真や文章がどれだけ自然に見えても、それだけで事実と決めつけないようにする姿勢が重要です。

- 出典と文脈を確認する – 誰が、いつ、どのような形で発信した情報なのかを一度立ち止まって確かめることで、AI生成コンテンツに振り回されにくくなります。

- AIが関わっている可能性を前提にする – 会話、画像、顔のいずれもAIが生成しうるという前提に立つことで、「そもそもこれは本当に人が作ったものか」という視点を持ちやすくなります。

2025年のAIと、これからの私たち

2025年現在、AIはビジネスや創作の現場で大きな可能性を広げる一方で、フェイクや誤情報のリスクも現実のものになりつつあります。メアリー・ミーカー氏のAI報告書は、その両面を冷静に整理しながら、特にハイパーリアルなフェイクがもたらす課題に改めて光を当てています。

日々スマートフォンでニュースをチェックし、SNSで情報を共有する私たち一人ひとりが、AIによる合成コンテンツが身近な存在になっていることを前提に、情報との距離感を更新していく必要があります。

「見ても信じられない」時代に求められるのは、疑い続けることだけではなく、どの情報をどのように信頼するかを周囲と対話しながら考えていく姿勢です。AIが作ったものと人が作ったものが混ざり合う2025年の情報環境を、私たちはどのように読み解き、次の世代へと引き継いでいくのか。日々のニュースの読み方を見直すきっかけとして、この報告書の提示する視点を共有していきたいところです。

Reference(s):

When seeing isn't believing: Report warns of hyper-realistic fakes

cgtn.com